„100Gbps marketing”, aneb jak se nenechat nachytat

100Gbps technologie není záruka kvalitního připojení. Dejte si pozor na následující faktory:

Pojďme se podívat na to, jaké prvky v páteřní síti hostingových firem či telekomunikačních operátorů reálně ovlivňují kvalitu připojení a dostupnost.

100Gbps – inovace nebo marketing?

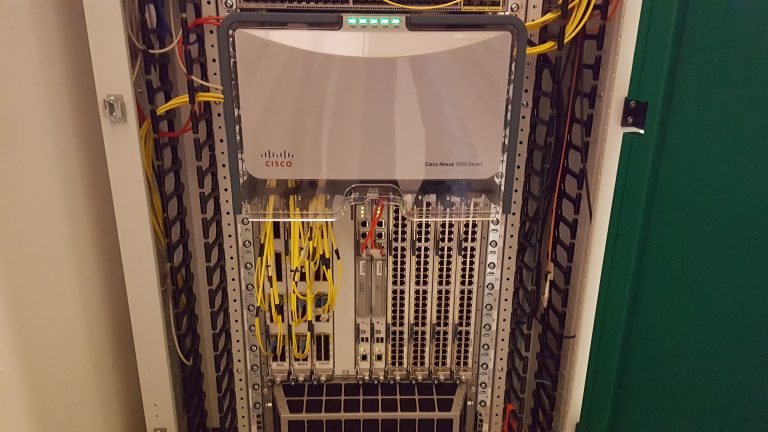

100Gbps technologie je naprosto běžnou součástí páteřních sítí a ceny síťových prvků klexsají. Například Nexus 3232C, 1U switch disponující 32x 100Gbps porty vychází dnes po slevě kolem částky 300 000Kč: z pohledu páteřních sítových prvků drobná položka. Bez pochyb je dostatečná propustnost sítě naprostý základ stability, jde ale bohužel jen o jeden prvek, který je na tom všem reálně nejlevnější. Firmy chlubící se 100Gbps sítí ovšem často skrývají další aspekty sítě, které mají na reálnou spolehlivost větší vliv.

Čím se routuje?

Globální internet z pohledu počtu IP rozsahů propagovaných v routovacích tabulkách neustále roste. Je to zapříčiněno primárně tím, že z důvodu nedostatku IPv4 adres dochází na jejich „drobení“ až na malé rozsahy /24 a počet rozsahů v internetu tak roste.

Routery po světě, které od upstream providerů získávají plné routovací tabulky, mají mnohdy problém jakékoliv změny rychle přepočítat v rozumném čase. Často k tomu potřebují i více než 15 minut bez ohledu na to, jestli máte 1Gbps nebo 100Gbps. Routery jsou nejdražším prvkem v síti a často jde o nejslabší místo hostingových firem či providerů. Proto o routerech mnohdy vůbec nehovoří a chlubí se jen 100Gbps ?

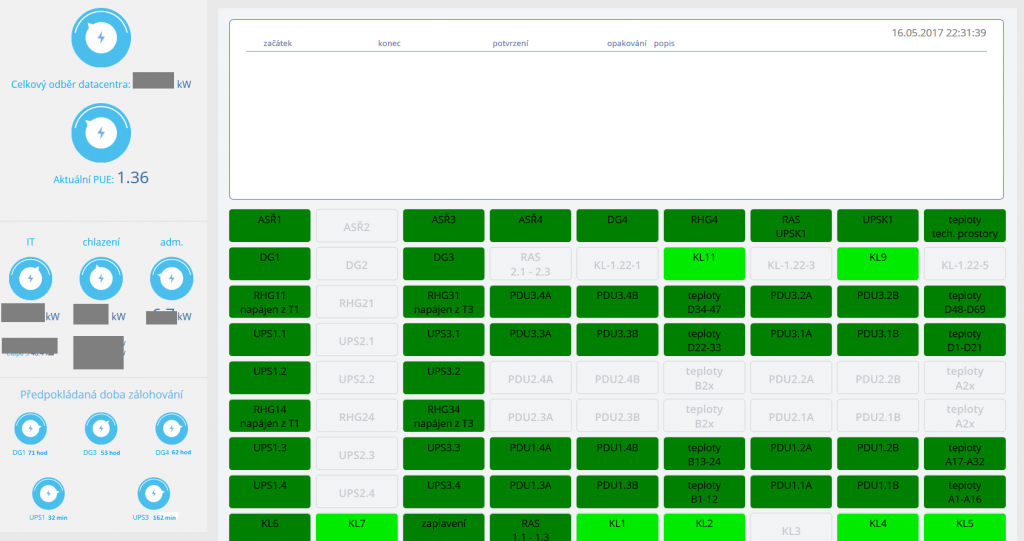

Ve vshosting~ disponujeme technologií podporující 100Gbps i kvalitními routery a vše jsme transparentně popsali v našem článku vhosting~ – jaký hardware používáme v síti.

S kým je poskytovatel propojen?

Další naprosto zásadní otázkou je to, s kým je daná hostingová firma propojena a s jak kvalitním operátorem. Za kvalitního operátora s dostatečnou infrastrukturou lze označit Tier1 operátory, jejichž seznam naleznete i na wikipedii. Je totiž možné, že i při 100Gbps portu nakonec dojde k saturaci u upstream providera, například při útoku, a reálně 100Gbps v ničem nepomůže.

Je také vhodné se podívat, zda je daný operátor připojen do nějakého peeringového centra a jakou rychlostí a s kým je tak napřímo propojen. Propojení v rámci peeringového centra (například NIX.CZ) totiž zkracuje propojení a mezi hostingovou firmou a koncovým uživatelem tak odpadá „mezičlánek“ v podobě upstream providera.

To má pozitivní vliv na rychlost, náklady i spolehlivost a hlavně rychlost při konvergenci.

Příklad: daný operátor má nějaký výpadek a přepne provoz mezi více uplinků. Pokud jste s operátorem propojeni napřímo, routery se rychleji „domluví“ a data mezi vašimi sítěmi budou rychleji obnovena.

100Gbps připojením do NIXu disponuje například zatím jen Microsoft, Seznam, T-mobile, Justin.tv (viz veřejné statistiky) a několik málo dalších, kteří své statistiky na webu nixu nezveřejňují.

Čím může být dále poskytovatel omezen?

Řada providerů disponující 100Gbps technologií má ve své síti zapojeny prvky, které ovšem reálně 100Gbps neumí využít. K saturaci a omezení dostupnosti tak dojde i při řádově menším trafficu. Jde například o různé IDS/IPS sondy postavené na Linuxu. Datovou analýzu provádí procesor serveru a to je v řadě míst nejslabší článek, kde by bylo mnohdy nutné pro zvládnutí 100Gbps trafficu disponovat stovkami jader, aby bylo možné takový traffic v reálném čase vyhodnotit.

Ověřte si, jak moc je váš poskytovatel transparentní a zda zveřejňuje informace o tom, čím routuje, s jakými providery je propojen a jak reálně vypadá topologie sítě. Síťařina je samostatný a komplexní obor a marketing firem se často schovává za líbivé pojmy jako „100Gbps síť“. Ve vshosting~ něco takového považujeme za samozřejmé :-). Do roka budeme pravděpodobně vzhledem k nárůstu trafficu upgradovat uplinky do NIXu ze 40Gbps na 2x 100Gbps.