Nekompromisní zabezpečení: jak jsme ve vshosting~ připraveni na apokalyptické scénáře

Podívejte se, jak chráníme servery a data našich klientů před typickými hrozbami: sabotáží serverů, blackoutem a poruchou chlazení.

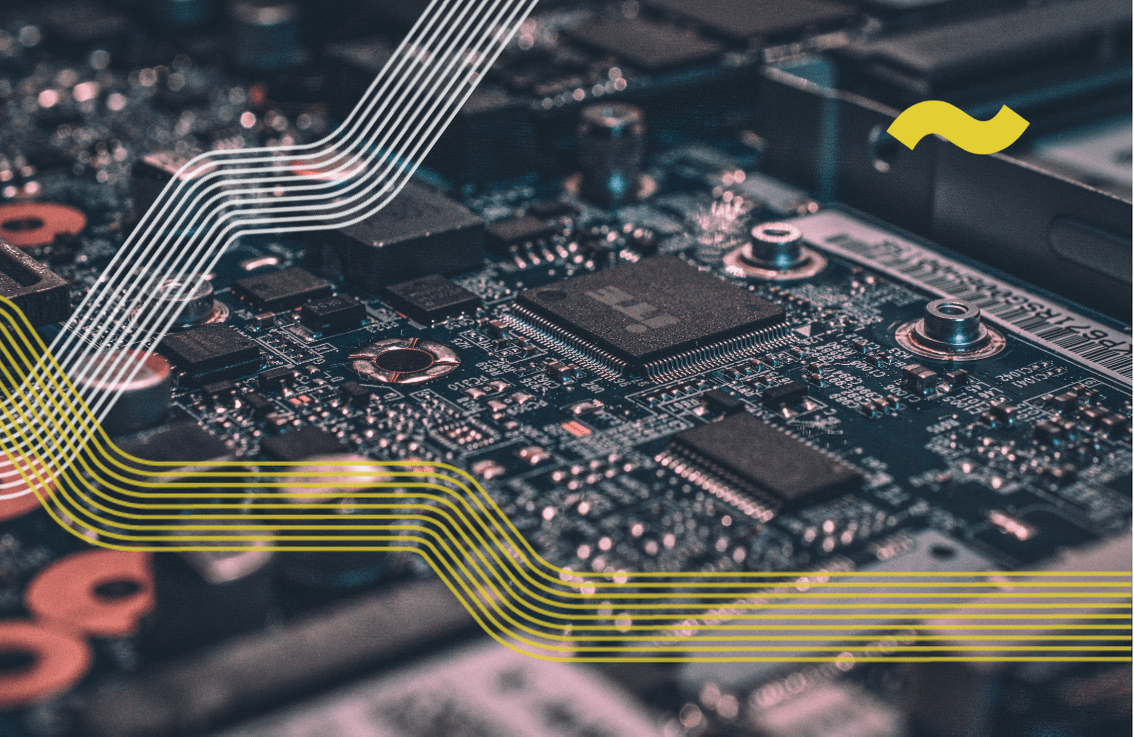

Asi nikoho nepřekvapí, že ve vshosting~ bereme bezpečnost smrtelně vážně. Občas si děláme legraci, že naše opatření hraničí s paranoiou. Ale to je naše práce. Jen díky extrémně přísným opatřením a do detailu vypracovaných krizových scénářů dokážeme provozovat datacentrum bez výpadků od jeho otevření v roce 2015 a zajistit našim klientům maximální spolehlivost.

Pro zajímavost poodhalujeme, jak chráníme servery a data našich klientů před třemi typickými hrozbami: sabotáží nebo krádeží serverů, dlouhým blackoutem a poruchou chlazení.

Apokalyptický scénář 1: Sabotáž či krádež serverů

Kdyby se náhodným vandalům nebo dokonce vaší konkurenci podařilo zmocnit se vašich serverů, byl by to pořádný průšvih. Nejen že by vaše aplikace (např. váš e-shop) přestaly fungovat, ale dotyční by mohli získat i vaše data. Naštěstí pokud jste svou infrastrukturu svěřili nám ve vshosting~, nic takového nehrozí.

Naše datacentrum ServerPark je v podstatě neproniknutelná železobetonová kostka s pancéřovými dveřmi, která je ještě navíc obehnaná vysokým plotem s ostnatým drátem.

Datacentrum ServerPark

Ani to nám ovšem nepřišlo dostatečně bezpečné, a proto jsme přidali sofistikovaný bezpečnostní systém včetně kamer, který se aktivuje jakmile by někdo například přelezl plot nebo se vlamoval do dveří. Do serverovny se dostanete jedině pomocí kombinace několika klíčů, čipů a přístupového kódu. Aby toho nebylo málo, všechny serverové racky jsou samostatně uzamykatelné, takže k jednotlivým serverům se skutečně jen tak někdo neprobojuje.

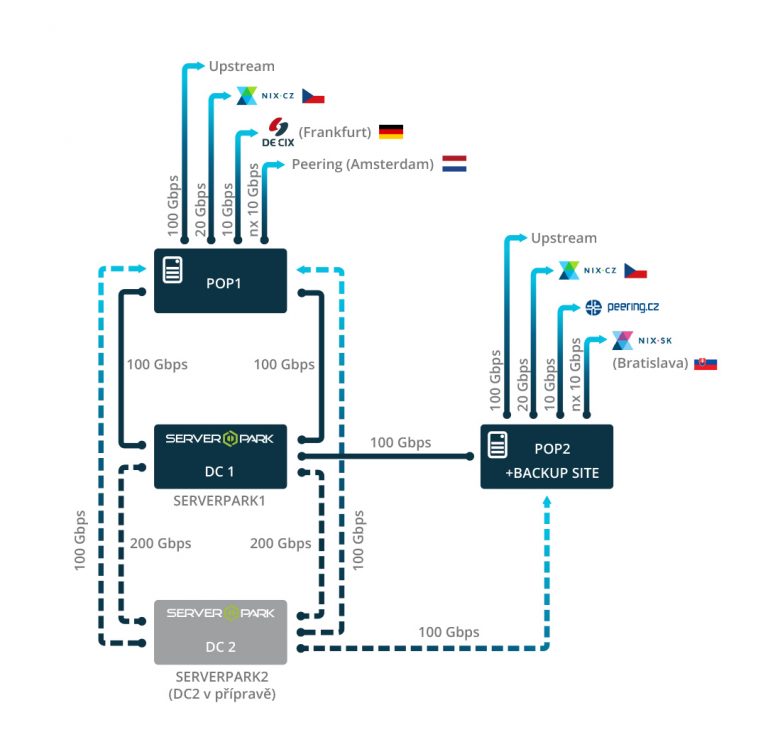

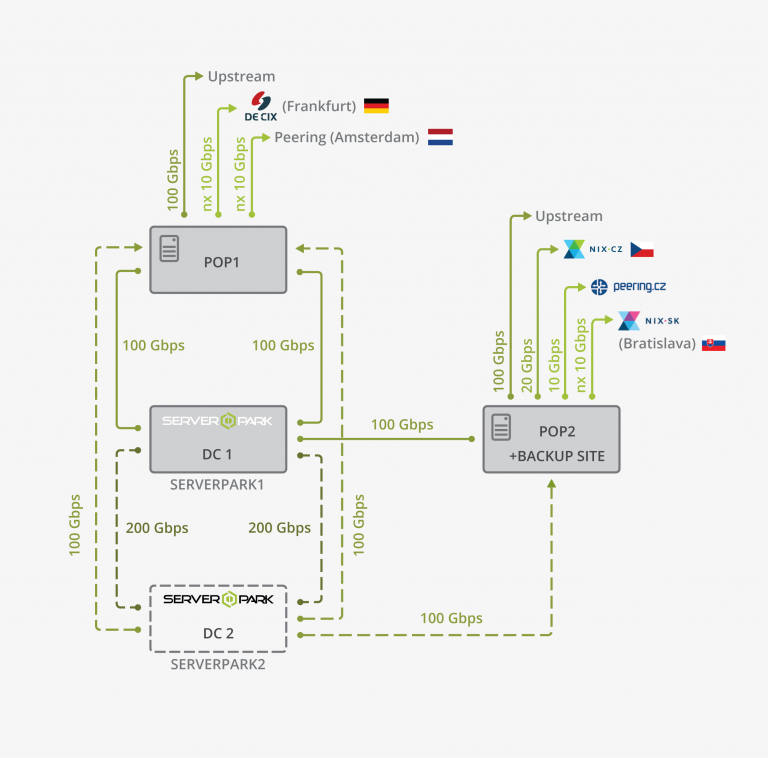

Za zmínku stojí i naše ochrana před sabotáží kybernetickou: DDoS útoky. Ty se dají poměrně snadno a levně objednat online a útočníci pak mohou přetížit vaši aplikaci a v podstatě ji vyřadit z provozu. Proto jsme vyvinuli vlastní anti-DDoS ochranu, která těmto útokům účinně brání. Sabotéři tedy budou mít smůlu i pokud zvolí softwarovou cestu.

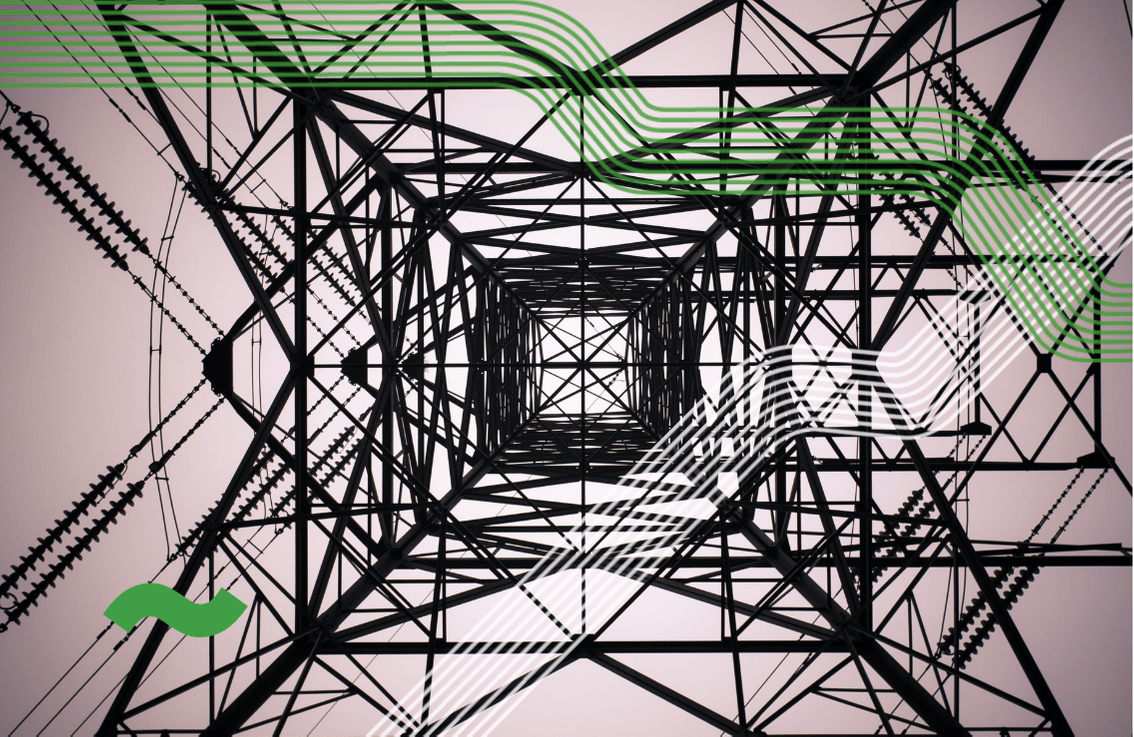

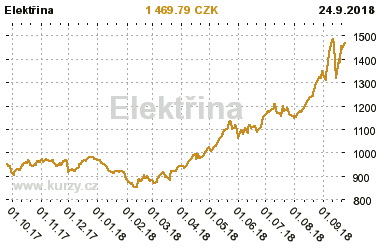

Apokalyptický scénář 2: Několikadenní výpadek elektřiny

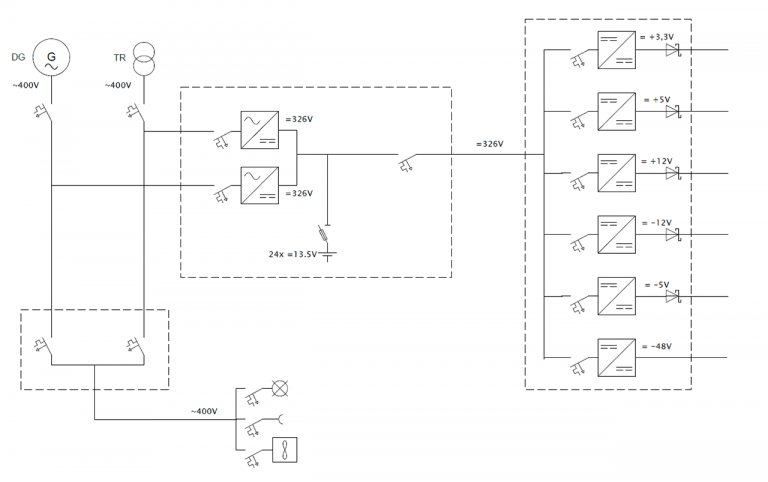

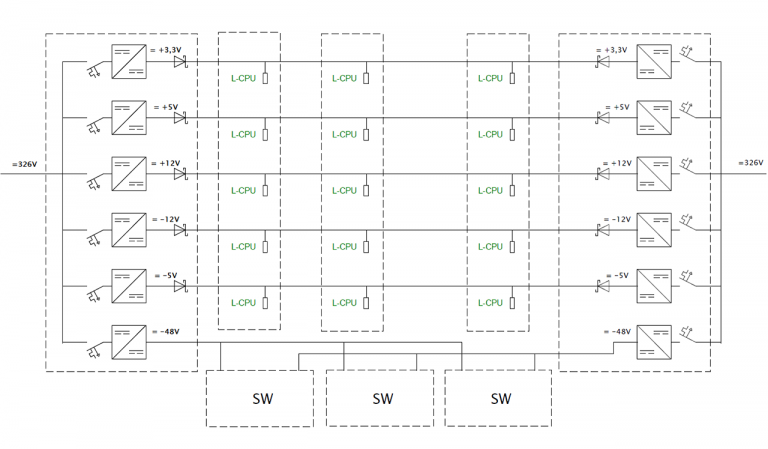

Zloději, sabotéři i jiní záškodníci jsou tedy eliminováni, ale co kdyby, řekněme, vypadl proud? Datové centrum spotřebovává obrovské množství elektrické energie – jak bychom tedy zvládli blackout? A co teprve, kdyby výpadek elektrické sítě trval třeba týden? Přesně pro tento případ jsme v ServerParku nainstalovali komplexní systém sestávající z UPS, tj. bateriový záložní zdroj, dieselových generátorů a nádrže na diesel.

2 ze 3 dieselových generátorů v datacentru ServerPark

Všechny tyto prvky u nás navíc provozujeme v takzvaném režimu nx2 a n+1. To v praxi znamená, že v ServerParku máme zapojené dvě naprosto nezávislé napájecí větve (režim nx2). Ka každé větvi je přiřazeno jedno dedikované a jedno „rezervní“ UPS (režim n+1) a každá větev disponuje vlastním diesel generátorem i rozvaděčem. Současně je zapojen i další diesel generátor, který se automaticky zapne, kdyby došlo k poruše některého z dedikovaných generátorů.

Každá napájecí větev také disponuje vlastní sadou baterií a každá sada baterií je složena ze 3 stringů. Je to z toho důvodu, že baterie jsou ve z technických důvodů stringu zapojeny v sérii, takže kdyby by došlo například ke špatnému kontaktu mezi dvěma bateriemi, může dojít k selhání celého stringu. Servery u nás také mají mít instalované 2 zdroje a jsou současně zapojeny do obou nezávislých větví: na nezávislé UPS, nezávislé rozvaděče a nezávislé generátory.

Co by se tedy dělo v případě výpadku? Datacentrum by se automaticky začalo napájet z bateriového systému, zatímco by startovaly dieselové generátory. Naše baterie datacentrum „utáhnou“ déle než 20 minut, což poskytuje velkou rezervu k plnému rozběhnutí generátorů. Poté už by vše běželo na elektřinu vyrobenou z dieselu. Na tu vydržíme jet z vlastních zdrojů více než dva týdny. Pro představu, to je násobně větší rezerva, než má většina nemocnic.

Apokalyptický scénář 3: Porucha chlazení serverového sálu

Blackout jsme tedy zvládli, jsou tu ale i další potenciální zdroje problémů. Takové datacentrum je koneckonců plné elektroniky – co když se nějaká porouchá? A co když to bude zrovna zásadní prvek datacentra, jako třeba chladicí systém?

Servery vyrábějí spoustu tepla, je tedy potřeba je intenzivně chladit, aby se nepřehřívaly. Když dosáhnou moc vysoké teploty, může dojít k jejich poškození, zničení nebo dokonce začít hořet. Proto máme v ServerParku nainstalovaný naddimenzovaný systém chlazení i profesionální hasicí systém na bázi plynu FM200. Na hašení by ale dojít nemělo – servery mají zároveň pojistky, které je při přehřátí vypnou.

Hasicí systém FM200 v serverovém sálu ServerParku

Náš systém chlazení je podobně naddimenzovaný jako napájení: klimatizačních jednotek i všech dalších prvků máme 2x více, než je potřeba, plus ještě jednu záložní. Mnoho datacenter má pouze tu jednu zálohu, my jsme se s ní však nespokojili. Selhání chlazení je u nás tedy asi tak pravděpodobné, jako že do vás uhodí blesk, zatímco na obloze nebude jediný mrak.

Jak vidíte, naše datacentrum ServerPark je připraveno na nejhorší: ať už jde o pokus o sabotáž, výpadek proudu nebo možnost poruchy, kvalitu našich služeb to neovlivní. Díky našemu nekompromisnímu zabezpečení (i mnoha dalším výhodám) nám svoje projekty svěřili i ty největší české a slovenské internetové firmy. Pokud se chcete dozvědět, jak navzdory pandemii koronaviru zachováváme 100% provoz, přečtěte si náš předchozí článek.